Por Brandy Zadrozny — NBC News

En el verano de 2019, una nueva usuaria de Facebook llamada Carol Smith se registró en la plataforma, describiéndose como una madre políticamente conservadora de Wilmington, Carolina del Norte. La cuenta de Smith indicaba un interés por la política, la maternidad y el cristianismo, y seguía a algunas de sus marcas favoritas, como la cadena Fox News y al entonces presidente Donald Trump.

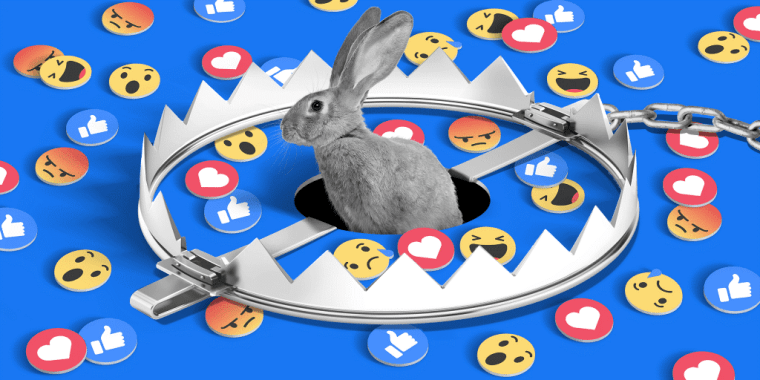

Aunque Smith nunca había expresado su interés por las teorías de la conspiración, en solo dos días Facebook le recomendó que se uniera a grupos dedicados a QAnon, un movimiento y una teoría de conspiración extensa y sin fundamento que afirmaba que Trump, en secreto, estaba salvando al mundo de una cábala de pedófilos y satanistas.

Smith no siguió los grupos de QAnon recomendados, pero el algoritmo que Facebook utiliza para determinar cómo debía participar en la plataforma siguió haciendo su tarea. En una semana, el feed de Smith estaba lleno de grupos y páginas que habían violado las normas de Facebook, incluidas las que prohíben la incitación al odio y la desinformación.

Pero Smith no era una persona real, sino un investigador contratado por Facebook que inventó la cuenta, junto con las de otros “usuarios de prueba” ficticios en 2019 y 2020, como parte de un experimento para estudiar el papel de la plataforma en la desinformación y polarización de los usuarios a través de sus sistemas de recomendaciones.

Ese investigador expresó que la experiencia de Smith en Facebook fue “un aluvión de contenido extremo, conspirativo y gráfico”.

El conjunto de investigaciones ha demostrado sistemáticamente que Facebook empuja a algunos usuarios a lugares oscuros, donde se alimentan los prejuicios y las teorías conspirativas de los usuarios.

Las personas radicalizadas a través de estas madrigueras constituyen una pequeña porción del total de usuarios, pero a la escala de Facebook, eso puede significar millones de individuos.

Los hallazgos, comunicados en un informe titulado El viaje de Carol a QAnon, se encuentran entre miles de páginas de documentos de las revelaciones hechas a la Comisión de Valores y Bolsa y proporcionadas al Congreso en forma redactada por el asesor legal de Frances Haugen, quien trabajó como gerente de producto de Facebook hasta mayo.

Haugen hizo valer su condición de denunciante y presentó varias quejas específicas de que Facebook antepone los beneficios a la seguridad pública. A principios de este mes, testificó sobre sus acusaciones ante un subcomité del Senado.

Las versiones de las revelaciones, que redactaron los nombres de los investigadores, incluido el autor de El viaje de Carol a QAnon, se compartieron digitalmente y fueron revisadas por un consorcio de organizaciones de noticias, incluida nuestra cadena hermana NBC News.

Hace un mes, The Wall Street Journal publicó una serie de informes basados en muchos de los documentos.

“Aunque se trataba de un estudio sobre un usuario hipotético, es un ejemplo perfecto de la investigación que la compañía realiza para mejorar nuestros sistemas y ayudó a sustentar nuestra decisión de eliminar a QAnon de la plataforma”, declaró un portavoz de Facebook en respuesta a preguntas enviadas por correo electrónico.

El CEO de Facebook, Mark Zuckerberg, ha negado ampliamente las afirmaciones de Haugen, defendiendo el “programa de investigación líder en la industria” de su compañía y su compromiso “para identificar los problemas importantes y trabajar en ellos”.

Los documentos publicados por Haugen respaldan en parte esas afirmaciones, pero también ponen de manifiesto las frustraciones de algunos de los empleados que participan en esa investigación.

Entre las revelaciones de Haugen hay investigaciones, reportes y publicaciones internas que sugieren que Facebook sabe desde hace tiempo que sus algoritmos y sistemas de recomendación empujan a algunos usuarios a los extremos.

Y mientras algunos directivos y ejecutivos ignoraban las advertencias internas, grupos antivacunas, fanáticos de las teorías conspirativas y agentes de desinformación se aprovecharon de su permisividad, amenazando la salud pública, la seguridad personal y la democracia en general.

“Estos documentos confirman efectivamente lo que los investigadores externos venían diciendo desde hace años, y que a menudo era desestimado por Facebook”, aseveró Renée DiResta, directora de investigación técnica del Observatorio de Internet de Stanford y una de las primeras precursoras en denunciar los riesgos de los algoritmos de recomendación de Facebook.

La propia investigación de Facebook muestra la facilidad con la que un grupo relativamente pequeño de usuarios puede secuestrar la plataforma y, para DiResta, resuelve cualquier duda que pudiera quedar sobre el papel de la red social en el crecimiento de las corrientes conspirativas.

“Facebook ayudó literalmente a crear una secta”, declaró.

Un patrón en Facebook

Durante años, los investigadores de la compañía habían realizado experimentos como el de Carol Smith para medir la influencia de la plataforma en la radicalización de los usuarios, según los documentos vistos por NBC News.

Este trabajo interno descubrió repetidamente que las herramientas de recomendación empujaban a los usuarios hacia grupos extremistas, una serie de revelaciones que ayudaron a informar sobre los cambios de política, los ajustes en las recomendaciones y las clasificaciones de las noticias.

Esas clasificaciones son un sistema tentacular, en constante evolución, ampliamente conocido como “el algoritmo” que empuja el contenido a los usuarios. Pero la investigación de entonces no llegó a inspirar ningún cambio en los grupos y las páginas.

Esa resistencia era un indicio de “un patrón en Facebook”, explicó Haugen a los periodistas este mes. “Quieren el camino más corto entre sus políticas actuales y cualquier acción”, afirmó.

Haugen añadió: “Hay una gran reticencia a resolver los problemas de forma proactiva”.

Un portavoz de Facebook refutó que la investigación no había empujado a la compañía a actuar y señaló los cambios en los grupos anunciados en marzo.

Mientras los seguidores de QAnon cometieron actos de violencia en el mundo real en 2019 y 2020, los grupos y páginas relacionados con la teoría de la conspiración se dispararon, según documentos internos.

Los escritos también muestran cómo los equipos dentro de Facebook tomaron medidas concretas para entender y abordar esos problemas, algunos que los empleados consideraron eran poco y demasiado tarde.

En el verano de 2020, Facebook albergaba miles de grupos y páginas privadas de QAnon, con millones de miembros y seguidores, según una investigación interna no publicada.

Un año después de que el FBI designó a QAnon como una potencial amenaza terrorista nacional a raíz de los enfrentamientos armados, los secuestros, las campañas de acoso y los tiroteos, Facebook etiquetó a QAnon como una “red de conspiración que incita a la violencia”, y la prohibió en la plataforma, junto con las milicias y otros movimientos sociales violentos.

Un pequeño equipo que trabajaba en varios departamentos de Facebook alojó cientos de anuncios en dicha red social y en Instagram por valor de miles de dólares y millones de visitas, “alabando, apoyando o representando” la teoría de la conspiración.

El portavoz de Facebook manifestó en un correo electrónico que la compañía ha “adoptado un enfoque más agresivo en la forma de reducir el contenido que probablemente viole nuestras políticas, además de no recomendar grupos, páginas o personas que publican regularmente contenido que probablemente viole nuestras políticas”.

Para muchos empleados dentro de Facebook, la aplicación de la normativa llegó demasiado tarde, según los mensajes dejados en Workplace, el foro de mensajes internos de la compañía.

“Sabemos desde hace más de un año que nuestros sistemas de recomendación pueden llevar muy rápidamente a los usuarios por el camino de las teorías y grupos conspirativos”, escribió una investigadora de integridad, cuyo nombre había sido redactado, en un post en el que anunciaba que dejaba la compañía.

“Este grupo marginal ha crecido a la prominencia nacional, con candidatos al Congreso de QAnon y los hashtags y grupos de QAnon son tendencia en la corriente principal. Estábamos dispuestos a actuar solo *después* de que las cosas se hubiesen salido de control”, lamentó.

"Deberíamos estar preocupados"

Si bien parece que en un inicio la prohibición de Facebook fue efectiva, hubo un problema que persistió: eliminar grupos y páginas no eliminó a los seguidores más extremos de QAnon, que continuaron organizándose a través de la plataforma.

“Hubo suficiente evidencia para alertar a la comunidad de expertos porque Facebook y otras plataformas no lograron abordar la dimensión extremista y violenta de QAnon”, dijo Marc-André Argentino, investigador del Centro Internacional para el Estudio de la Radicalización del King’s College de Londres, quien ha estudiado a QAnon de manera extensiva.

Los seguidores de esta teoría conspirativa simplemente cambiaron de nombre, bautizándose como grupos contra la trata de niños, o emigraron a otras comunidades, incluidas las que se encontraban en torno al movimiento antivacunas.

Otros pasaron a los grupos que promovían las mentiras de Donald Trump sobre un supuesto fraude electoral en su contra en las elecciones presidenciales de 2020. Muchas de las personas que terminaron asaltando al Capitolio estaban activas en estos grupos de Facebook, según un reporte incluido en estos documentos, del que reportó primero BuzzFeed News en abril.

Los investigadores advirtieron que una de los motivos por los que Facebook no ha podido detener a estos grupos es porque se ha enfocado en ellos de manera individual y no los ha tratado como un movimiento cohesionado.

"Un dolor de cabeza"

El ataque al Capitolio provocó un momento de autocrítica para los empleados.

Uno de los equipo notó que las lecciones que aprendieron sobre el QAnon los advertían en contra de ser demasiado permisivos con el contenido del movimiento antivacunas, que según los investigadores llegó a comprender la mitad de las impresiones sobre las vacunas en toda la plataforma.

El equipo de 'Contenido peligroso' de Facebook formó un grupo de trabajo a principios de 2021 para encontrar formas de lidiar con el tipo de usuarios que habían sido un desafío para la red social: comunidades como QAnon, negacionistas del COVID-19 y el movimiento incel misógino que no constituyen grupos terroristas o de odio obvios, pero que, por su naturaleza, plantean un riesgo para la seguridad de las personas y las sociedades.

El objetivo no era erradicarlos, sino frenar el crecimiento de estas “comunidades de temas dañinos”, con las mismas herramientas algorítmicas que les habían permitido crecer sin control.

“Sabemos cómo detectar y eliminar contenido dañino, actores adversariales y redes coordinadas maliciosas, pero aún tenemos que comprender los daños adicionales asociados con la formación de comunidades dañinas, así como como lidiar con ellos”, escribió el equipo en un informe de 2021.

Un grupo de Facebook bautizado como Drebbel, por el ingeniero holandés del siglo XVII Cornelis Drebbel, fue encargado con descubrir cómo es que los usuarios se radicalizan para bloquear estos caminos en Facebook e Instagram.

El grupo trabaja con el programa para "desamplificar" los grupos extremistas y la información falsa. En marzo, los investigadores hallaron que muchos de los usuarios que participaban en la comunidad QAnon llegaron a través de grupos que actúan como puertas de entrada. Creen que pueden poner obstáculos para que los usuarios no lleguen a estos grupos, del mismo modo en el que antes sus algoritmos los dirigen a estos.

“Descubrimos, como muchos problemas en FB, que este es un dolor de cabeza con una cantidad relativamente pequeña de actores que crean un gran porcentaje del contenido y el crecimiento”, escribió el grupo.

El portavoz de Facebook dijo que la compañía se había “centrado en los resultados” en relación con el COVID-19 y que había visto una disminución del 50% entre los contenidos que desvirtúan la eficacia y la seguridad de las vacunas, según una encuesta que realizó junto con la Universidad Carnegie Mellon y la Universidad de Maryland.

Está por verse si las iniciativas de integridad más recientes de Facebook podrán detener el próximo movimiento peligroso de la teoría de la conspiración o la organización violenta de los movimientos existentes. Pero sus recomendaciones políticas pueden tener más peso ahora que la violencia del 6 de enero puso al descubierto la enorme influencia y los peligros que representan incluso las comunidades extremistas más pequeñas y la desinformación que alimentan.

El poder de la comunidad, cuando se basa en temas o ideologías dañinas, representa una amenaza mayor para nuestros usuarios que cualquier contenido, actor adversario o red maliciosa”

Informe de facebook de 2021

El portavoz de Facebook agregó que las recomendaciones en la 'Hoja de ruta de desamplificación' ya se están implementando: “Este es un trabajo importante y tenemos un largo historial de uso de nuestra investigación para hacer cambios informados en nuestras aplicaciones”, escribió el portavoz. “Drebbel es coherente con este enfoque, y su investigación ayudó a informar nuestra decisión de este año de dejar de recomendar grupos cívicos, políticos o de noticias en nuestras plataformas de forma permanente. Estamos orgullosos de este trabajo y esperamos que continúe informando las decisiones sobre productos y políticas en el futuro”, concluyó.